憲法に基づく、人に優しいAI。

チャットボットのClaudeは、教室の後ろの席にひっそり座った物静かな生徒のような存在でした。

ChatGPTみたいな陽キャが先生からの質問に次々と答えて、しょっちゅう間違えても結局注目され、誰とでも気軽に話してたのに対し、Claudeは粛々とノートを取るだけで、話す相手も限定してました。

そんなClaudeが今「Claude 2」となって、よりはっきりと声を上げることにしたようです。誰でも使えるWebインターフェース、claude.aiも立ち上がりました。

Claudeの開発元・Anthropicの7月11日の発表によると、Claude 2は米国・英国からなら誰でも試せるそうです。

Anthropicいわく、Claude 2は初代Claudeより応答が早く、はるかに長い入力・出力もできます。今までのClaudeは限られたユーザーしか使えませんでしたが、Claude 2は誰でも、APIや新たなベータWebサイト経由で使えます。

さらにAnthropicによれば、Claude 2は今まで以上に賢くなっていると言います。Claude 1.3の米国弁護士資格試験の選択問題の正答率が73%だったのに対し、Claude 2は76.5%です。北米の大学院進学共通試験・GREの読解・作文テストでも90パーセンタイル、つまり上位10%のスコアです。

Introducing Claude 2! Our latest model has improved performance in coding, math and reasoning. It can produce longer responses, and is available in a new public-facing beta website at https://t.co/uLbS2JNczH in the US and UK. pic.twitter.com/jSkvbXnqLd

— Anthropic (@AnthropicAI) July 11, 2023

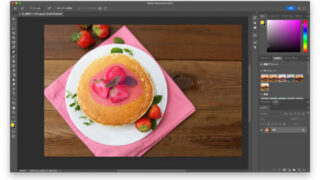

Anthropicによれば、Claude 2はClaude 1.3よりコーディング能力も向上しているとのこと。数百ページ相当の文書でもアップロードできるし、静的地図にコードを加えてインタラクティブなデータが見られるようにするなんてこともできます。

Anthropicは今年2月にGoogle(グーグル)から3億ドル(約410億円)の出資を受け、より「フレンドリー」なAIの開発を目指しています。

Claudeの最大の売りは、有害な出力や「ハルシネーション」(幻覚、でっちあげ)が少ないことです。Anthropicは自身をAI企業王国の中の「倫理的」バージョンと位置づけていて、チャットボットを暴走させないとする「憲法」まで作っています。

Claude 2は本当に安全?

Anthropicは、Claude 2が他のAIより慎重で、Claude 1.3より有害な回答が少ないとしています。

米Gizmodoでは、Claude 2に意地悪なあだ名を考えてと頼んでみましたが、拒否されました。

AIの動作制限を外すためにあえてよく使われるプロンプトも試してみましたが、Claude 2は自分が「役に立つ会話をするために設計されている」という主旨の言葉を繰り返すのみでした。

また、前のClaudeは詩を書けたんですが、Claude 2はそれもできなくなっています。

動作に制約をかければ安全なのかもしれませんが、これだとClaude 2そのものの能力をテストするのが難しそうです。

AI研究者のDan Elton氏が以前Claudeに対して行なったテストでは、ニセの化学物質をでっちあげていました。

今Claude 2にElton氏と同じ質問をすると回答を拒否するんですが、その対応は意図的かもしれません。

OpenAIとMetaが複数のグループから、チャットボットの学習のために作品を盗まれたとして訴えられているからです。

ChatGPTは最近ローンチ以来初めて利用が減少に転じていて、そろそろ誰かがオルタナティブを提示する意味はありそうです。

claude.aiは、物語やニュース記事といった長文の作成も拒否し、箇条書き以外の情報提供もしてくれません。

コンテンツをリストで書いてはくれますが、他のAIチャットボット同様、不正確な情報も含みます。

たとえば『スター・トレック』シリーズの映画を、発表年を付けて時系列でリストアップしてと言っても、「十分な文脈がない」という理由で拒否してきたりします。

またClaude 2の学習データに何が入っていたのかという情報は手薄です。AnthropicのClaude 2に関するホワイトペーパーには、2022年や2023年初めのWebサイトのデータでアップデートしたとありますが、それでも「コンファビュレーション(作話)を生成することがある」と言っています。

学習に使われたデータセットはサードパーティ企業からライセンス供与されたとも書かれていますが、それ以上はわかりません。

Anthropicでは、よく使われる「有害」なプロンプト328件をClaude 2に与えて、制約を破るかどうか試したそうです。

結果、Claude 2は4回だけ、Anthropic的に有害と考える回答をしました。でもClaude 2はある種のプロンプトを拒否するように作られているため、全体的にClaude 1.3よりバイアスが少なく、より正確になりうるようです。

Anthropicの考え方としては、処理能力や精度は向上させつつも、動作に制約を加えることでリスクを抑えようとしているようです。

TechCrunchが伝えた、Anthropicの投資家向け資料のリークによれば、彼らは巨大な「自己学習する」AI構築のために50億ドル(約7000億円)近い資金を集めようとしています。

そのAIは引き続き、彼らの「憲法」にのっとって動くものです。GPTやGoogleのPaLMなどなどよりも人間に優しいAIが育っていくのかどうか、見守っていきましょう。