日本電気株式会社(NEC)は7月6日、独自に収集・加工した多言語データを用いた大規模言語モデル(LLM)を開発したと発表した。高い性能を実現しつつ、パラメーターを130億に抑えていることを特徴としており、軽量かつ高速で、消費電力も抑制できるとしている。

同LLMは、事前学習済みで、具体的な業務に対応した下流タスクのためのファインチューニングなどは行われていないファウンデーションモデル(基盤モデル)。多言語データにより学習したモデルながら、日本語における高い性能を有しており、同社が日本語言語理解ベンチマーク「JGLUE」を使って評価したところ、知識量に相当する質問応答で81.1%、推論能力に相当する文書読解においては84.3%と世界トップレベルの性能を達成したという。

高い性能を有しながら、130億パラメーターとコンパクトであることも特徴としている。GPU1枚搭載の標準的なサーバで動作でき、アプリケーションのレスポンスもよくなり、業務運用時の電力消費やサーバコストも抑えられるという。また、業務に特化させたLLMが短期間で容易に構築でき、ユーザーのオンプレミス環境でも動作可能なため、秘匿性の高い業務にも安心して利用できるとしている。

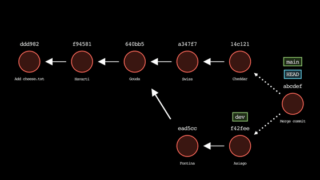

LLMは、パラメーター数が性能を示す1つの指標として見られるが、パラメーター数が多いことで、動作環境の要求も重くなる。同社では、今回のLLMの開発にあたって、学習に使われた高品質なデータの量や学習時間に左右されることに着目。パラメータサイズをGPU1枚で動作する範囲に抑えた上で、多量のデータと膨大な計算時間をかけることで、性能の向上を図った。

同LLMは、すでに同社の業務で活用を始めており、文書作成や社内システム開発におけるソースコード作成業務など、様々な作業の効率化に応用しているという。