AIがより自然に人間らしくなるのがゴールなら、そりゃAIだって100回聞くより1回見たほうがわかりやすいよね。

Google(グーグル)の開発者向け会議Google I/O。今年はAIにフルコミットされ、基調講演ではAI関連の発表がたくさんありました。そんなGoogleなので、もちろん進行中のAIプロジェクトはたくさんあるでしょう。

その中の1つがGoogle I/Oで公開されたプロジェクトAstra。マルチモーダルのAIアシスタントで、カメラを目として使ってまわりの状況を理解、それについてユーザーと会話が可能です。Google I/O開催直前に公式が公開したあの動画を可能にする技術です。

現地の米Gizmodoがさっそく体験してきました。

ほんの数分でしたけど、プロジェクトAstraが実際どんな様子なのかを体験してきました。使った端末はPixel 8 Proです。触れられたのは数分なのですべてを試すことはできなかったものの、「なるほど、こんな感じなのかぁ」は味わえました!

ちなみに、デモを見た後・体験前にわかったのですが、あの動画みたいにスムーズな会話ができるかはビミョー。というのも、Gemini(GoogleのAI)のあの部分はまだ超初期段階にあるからだそう。

ほぼなんでも答えてくれる

プロジェクトAstraの肝にあるのは、現実できちんとサポートできるアシスタントという考え。ユーザーの入力するテキストや音声だけでなく、ユーザーの周辺にあるもの、雰囲気、表情、質感をくみとりアシストできてこそなのです。ユーザーのあれどこに置いたっけ?までもサポートしたいのです。

4つの体験デモ

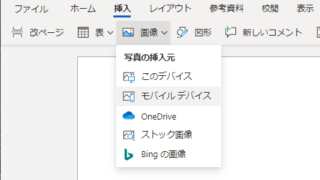

体験は、準備された4つのデモから選んで行なわれました。

ストーリーテラーモード:これは基調講演でもあったユーザーのリクエストに応じてお話しを作って聞かせてくれるやつ。

ピクショナリー:コンピューターとお絵描きクイズ的なやつ。

アリタレーション:最初の文字が同じ単語を繋げていくゲームのようなもの。

フリーモード:自由に質問、会話ができます。

私が体験できたのはフリーモード。

同じ体験グループにいた他社の記者にPixel 8 Proのカメラを向けてみたところ、Geminiが何を見ているのかを認識。男性ということだけでなく、手にスマホを持っていることまで理解しました。服についてたずねると「カジュアルな服のようですね」と。彼は何しているの?とたずねると「サングラスをかけてカジュアルなポージングをしているようです」と。実際、このとき、この記者はサングラスを着用していました。

その後、近くにあった造花の鉢植えを移すと、Geminiはそれも認識。花がチューリップであること、色とりどりであることを返してきました。が、これが造花かどうかわかったは不明。

と、ここでタイムアップ。もっと試してみたかったけど、残念。

デモで感じたこと

ほんの一瞬ですが、使ってすぐ感じたのは、ハンディキャップを持つ人の手助けになるということ。目が不自由な人の代わりに周辺を「見て」伝えることができます。

一番気になったのは、プロジェクトAstraが既存のGoogleアシスタントに置き換わるのかということ。現在、GoogleのトップAI Geminiと以前からアシスタントを務めていたGoogleアシスタントは共存しています。

が、GeminiがAstraの力を完全にモノにしたら、Googleアシスタントに勝ち目はないですね。まさか、どちらもAstraパワーを手にいれるとは思えないし…、そこは社内政治なのか…。気になったので、デモ担当の中の人にきいてみたのですが、ノーコメントでした。