「児童の性的搾取に関するデータ(CSAM)」の拡散を防ぐため、Appleは2021年8月、iCloudに保存されているデータからCSAMを検知する機能などの導入を発表しました。各方面から批判が相次ぐ当該機能について、プライバシー専門家が「かえってCSAMの拡散を招く」と指摘しています。

Influencing Photo Sharing Decisions on Social Media: A Case of Paradoxical Findings | IEEE Conference Publication | IEEE Xplore

https://ieeexplore.ieee.org/document/9152698

Could Apple’s child safety feature backfire? New research shows warnings can increase risky sharing

https://theconversation.com/could-apples-child-safety-feature-backfire-new-research-shows-warnings-can-increase-risky-sharing-167035

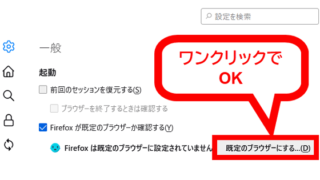

2021年8月5日、Appleは「メッセージアプリ」「iCloudに保存された写真」「Siriと検索機能」からデータをスキャンし、CSAMを共有しようとするユーザーに警告を発する機能を提供するなどの取り組みを発表しました。取り組みは、児童保護団体などからは賛同があった一方で、電子フロンティア財団を始めとする多方面からプライバシー保護に懸念があるなどとして、非難の声が上がりました。

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も – GIGAZINE

強い反発を受けて、Appleは9月3日に機能導入の延期を発表しました。

「iPhone内の児童ポルノ画像を検知する機能」の延期をAppleが発表 – GIGAZINE

インディアナ大学の心理学者であるカート・ヒューゲンバーグ氏らは、Appleが行おうとしていた「警告」という行為は、しばしば裏目に出てしまうことがあると述べています。実際、ヒューゲンバーグ氏らも不適切なコンテンツが共有されるのを防ぐためには警告という行為は適切なものだと考え1つの実験を行いましたが、予想に反する結果が明らかになったとのこと。

ヒューゲンバーグ氏らは400人以上を対象にさまざまな写真を見せて、「その写真が好きかどうか」「その写真を誰かと共有したいかどうか」といった質問をする実験を行いました。また、一部の参加者グループには「被写体のプライバシーを考慮してなお誰かと共有したいかどうか」とも質問しました。

その結果、「プライバシーを考慮すること」という注意を受け取った参加者グループは、注意を受け取らなかったグループに比べてその写真を共有したいと考える割合が高くなることが分かりました。また、アンケート結果なども含め「プライバシーを考慮するよう注意を受けた人は、自分と被写体との関係性が薄いということを意識するようになり、他人のプライバシーを危険に晒すということに関心が低くなるようだ」と結論付けられました。

この実験から、ヒューゲンバーグ氏らは「一部の人々は、Appleから警告を受けた場合、そのコンテンツを誰かと共有する傾向が強くなる可能性があります」と述べています。特に思春期の子どもはこの傾向が強く、子どもは仲間から「カッコイイ」と思われたがったり、親に対して反抗したかったりといった理由から性的に露骨な写真を共有することが多いとヒューゲンバーグ氏らは指摘しています。

ヒューゲンバーグ氏らは「Appleからの警告が『名誉のバッジ』として受け取られることも考えられます。『禁断の果実』のように、警告すればするほどリスクの高い共有が魅力的なものとして捉えられる危険があります」と述べました。

この記事のタイトルとURLをコピーする